Elice AI Cloud ML API

Deploy AI models at scale instantly and reliably

Access powerful AI models without infrastructure management, predictable costs.

From training to inference, everything you need for AI workloads

언어 혼합률은 낮추고, 한국 문화/역사에 대한 이해도는 높여 튜닝한 Llama 3.1 한국어 모델의 차이를 직접 경험해 보세요!

모델 성능 자세히 보기19X

throughput vs. official API

0%

inappropriate content

962

images/$

Accelerate ML workflow with Elice AI Cloud ML API

Scale with flexibility

Choose serverless for cost efficiency and flexibility, or dedicated resources for consistent performance at scale.

Deploy with performance

Run AI experiments on high-performance infrastructure with significant cost savings. Just $43 for 30 hours of inference.

Customize your pipeline

Adapt models to your needs using your own data with our comprehensive training infrastructure

Flexible way to deploy AI models

Available via dedicated instances and serverless API

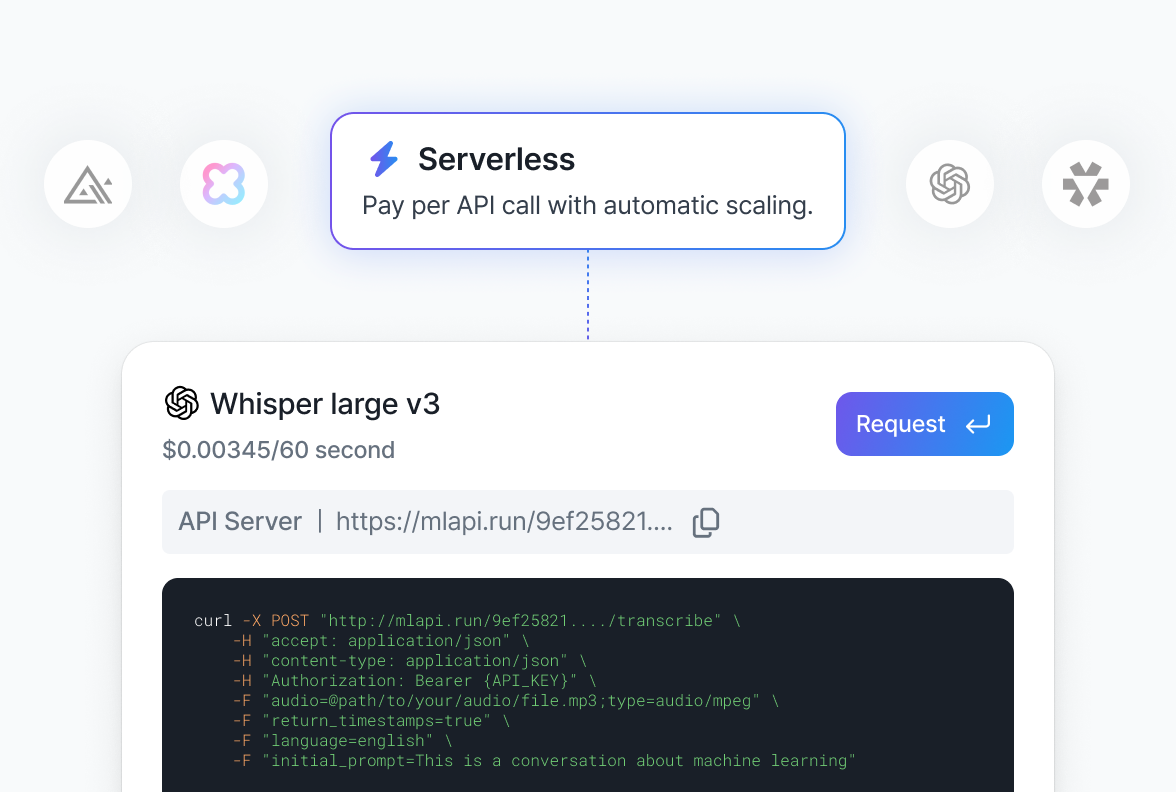

Serverless

Start fast, scale effortlessly with serverless inference

Deploy models in seconds without having to manage servers. Pay per API call with automatic scaling. Ideal for variable workloads and cost-efficient inference.

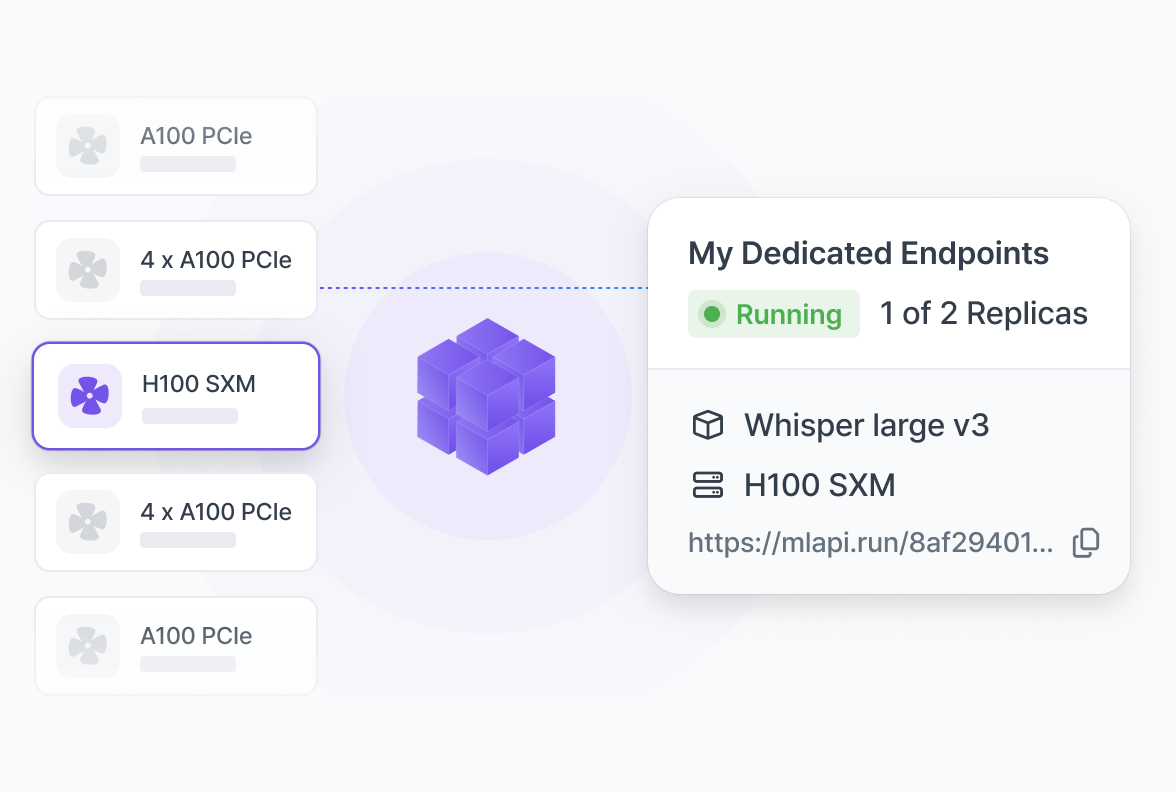

Dedicated

Provision dedicated endpoints for complete ML control

Get consistent performance with customized resources. Optimize configurations for reliable throughput in production. Perfect for high-volume, performance-critical workloads.

Explore our AI model library

Build with open-source and specialized models for research and more.

Are you ready to accelerate your AI workflow?